Apple s’apprête à révolutionner l’accessibilité grâce à une série de nouvelles fonctionnalités qui seront disponibles dans le courant de l’année. Ces améliorations comprennent le suivi oculaire pour l’iPad et l’iPhone, qui permettra aux utilisateurs souffrant d’un handicap physique de naviguer sur leurs appareils avec leurs seuls yeux. Music Haptics permettra aux utilisateurs sourds et malentendants d’apprécier la musique grâce aux vibrations raffinées du moteur Taptic de l’iPhone. Vocal Shortcuts introduit des sons personnalisés pour automatiser des tâches, tandis que Listen for Atypical Speech améliore la reconnaissance vocale pour les utilisateurs ayant des problèmes d’élocution. Vehicle Motion Cues vise à réduire le mal des transports grâce à des points animés afin de minimiser les conflits sensoriels pour les passagers des véhicules en mouvement. CarPlay bénéficiera de mises à jour telles que le contrôle vocal, les filtres de couleur et la reconnaissance sonore afin d’améliorer l’accessibilité. En outre, visionOS introduira le sous-titrage en direct dans tout le système, la prise en charge des appareils auditifs et des fonctions pour les utilisateurs malvoyants, renforçant ainsi l’engagement d’Apple en faveur d’une conception inclusive.

Concepteur : Apple

L’Eye Tracking utilise la caméra frontale de l’appareil et l’apprentissage automatique pour permettre aux utilisateurs de contrôler leurs appareils avec leurs yeux. Conçu pour les personnes souffrant d’un handicap physique, il offre un moyen simple et intuitif de naviguer sans nécessiter de matériel supplémentaire. Après une configuration et un étalonnage rapides à l’aide de la caméra frontale, les utilisateurs peuvent faire défiler les applications en regardant les éléments. Cette interaction peut déclencher des actions telles que des pressions sur des boutons, des glissements et d’autres gestes. Toutes les données sont traitées et stockées sur l’appareil, ce qui garantit la confidentialité de l’utilisateur. Cette fonction s’adapte aux habitudes individuelles grâce à l’apprentissage automatique, offrant ainsi aux utilisateurs souffrant de handicaps physiques un outil puissant pour naviguer facilement dans leurs appareils.

Music Haptics offre aux utilisateurs sourds et malentendants une nouvelle façon d’apprécier la musique grâce aux vibrations. Grâce au Taptic Engine, l’iPhone crée une réponse tactile synchronisée avec le rythme, la mélodie et l’intensité de la musique. Cette réponse tactile permet aux utilisateurs de ressentir la musique, ce qui la rend plus accessible et plus agréable. Music Haptics fonctionne avec des millions de chansons du catalogue Apple Music et est disponible sous la forme d’une API que les développeurs peuvent intégrer dans leurs applications, ce qui élargit encore son accessibilité. La fonction est conçue pour être facile à utiliser, avec des réglages simples pour l’activer et la désactiver.

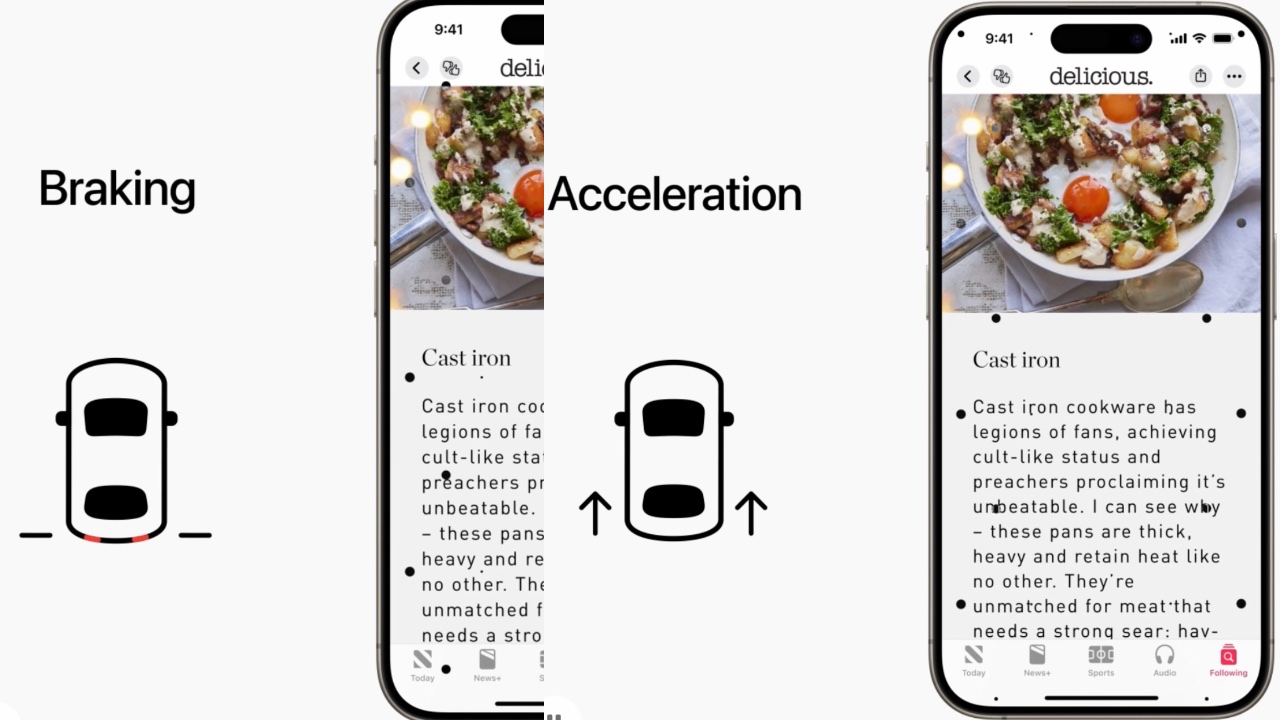

Les indices de mouvement du véhicule aident à réduire le mal des transports en affichant des points animés sur les bords de l’écran, alignant les informations visuelles sur le mouvement du véhicule. Cette fonction résout le conflit sensoriel qui est souvent à l’origine du mal des transports, lorsque ce qu’une personne voit ne correspond pas à ce qu’elle ressent. Grâce à des capteurs intégrés, cette fonction détecte si l’utilisateur se trouve dans un véhicule en mouvement et s’active automatiquement ou peut être activée dans le centre de contrôle. En fournissant une représentation visuelle du mouvement du véhicule, les signaux de mouvement du véhicule permettent aux utilisateurs de lire, de visualiser ou d’interagir plus facilement avec le contenu de leurs appareils sans ressentir de gêne.

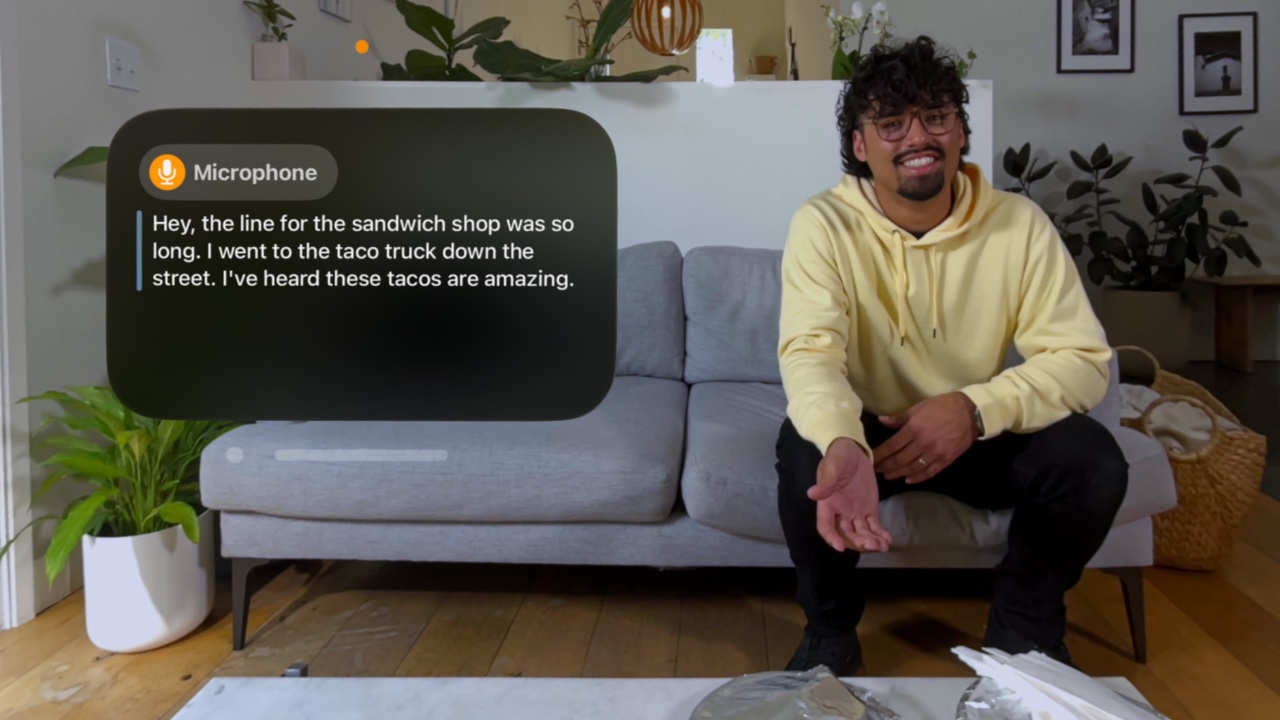

CarPlay bénéficiera également d’améliorations significatives, améliorant l’accessibilité pour les utilisateurs ayant des besoins divers. Le contrôle vocal permettra aux utilisateurs de naviguer et de contrôler les applications CarPlay à l’aide de leur voix, offrant ainsi une expérience mains libres. Les filtres de couleur rendront l’interface plus accessible aux daltoniens en ajustant l’écran pour distinguer les différentes couleurs. La reconnaissance sonore alertera les utilisateurs des sons importants, tels que les klaxons et les sirènes, afin que les conducteurs et les passagers sourds et malentendants soient conscients de leur environnement.

visionOS introduira le sous-titrage en direct à l’échelle du système, ce qui aidera davantage les utilisateurs sourds et malentendants en fournissant un sous-titrage en temps réel pour les dialogues parlés dans les conversations en direct et l’audio de l’application. La mise à jour élargira également la prise en charge des appareils auditifs Made for iPhone et des processeurs auditifs cochléaires, garantissant ainsi une intégration transparente avec Apple Vision Pro. Pour les utilisateurs malvoyants, de nouvelles fonctionnalités telles que la réduction de la transparence, l’inversion intelligente et l’atténuation des lumières clignotantes rendront l’interface plus confortable et plus facile à naviguer.

Ces avancées soulignent l’engagement d’Apple en faveur d’une conception inclusive, repoussant les limites de la technologie pour créer la meilleure expérience possible pour tous les utilisateurs. Pour célébrer la Journée mondiale de sensibilisation à l’accessibilité, Apple organisera des collections et des sessions dans certains Apple Stores, permettant aux utilisateurs d’explorer et de découvrir ces nouvelles fonctionnalités d’accessibilité. En innovant et en améliorant constamment l’accessibilité, Apple veille à ce que ses appareils restent accessibles à tous, permettant ainsi à tous les utilisateurs de profiter des dernières avancées technologiques.

The post Apple introduit des fonctions d’accessibilité qui permettent aux utilisateurs de contrôler l’iPad et l’iPhone avec l’oculométrie et de ressentir la musique avec la technologie haptique appeared first on Plare.